注釈の力が全てAIの誤認識を減らす=バカなデータは抹殺

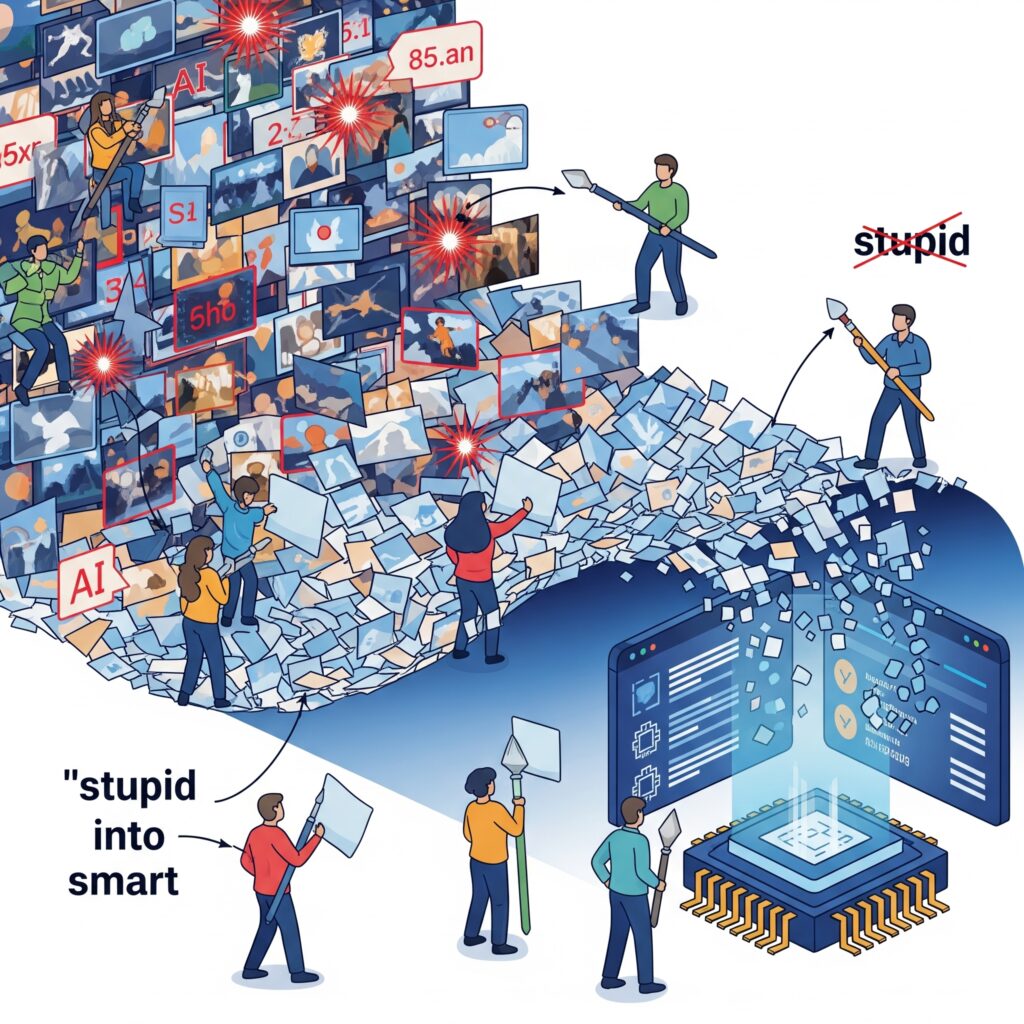

皆さん、アノテーションやってますか! AIモデルにおける“データの質”は、性能を大きく左右します。どんなに優れたアルゴリズムでも、誤認識の温床となる“バカなデータ”(質の低い、無意味な、あるいは誤った注釈)は排除されなければなりません。本記事では、なぜ注釈(アノテーション)がAIの誤認識を減らす鍵なのか、その効果的な運用方法から、Pythonによる実践サンプルまでを解説します。

目次

- なぜアノテーションがそんなに重要なのか?

- 「バカなデータ」の具体例と問題点

- 注釈精度を高めるための5つのポイント

- 業界事例:製造・医療・自動運転への応用

- Python実践:注釈データ処理サンプル

- まとめ:注釈主導のAI開発で信頼性を確保

- 参考リンク集

1. なぜアノテーションがそんなに重要なのか?

AIは教師あり学習によって正答を学びます。そのため、“正しい答え”を示すアノテーションがなければ何を学んでいいか分かりません。特に画像認識や自然言語処理では、誤ったラベルが学習に混ざり込むと、モデルは“その誤りを真実”として覚えてしまいます。これは医学診断や自動運転の現場では重大な結果につながる可能性があります。

2. 「バカなデータ」の具体例と問題点

以下は、しばしば見られる“バカなデータ”の例です:

- 誤ラベル:犬を「猫」と誤って注釈

- 曖昧な注釈:車画像に「交通」、車種が不明

- 重複データ:同じ写真が複数回含まれている

- ノイズラベル:無関係なタグが付与されている

こうしたデータが混在することで、モデルの精度は著しく落ち、一般化能力も低下します。つまり、AIの信頼性を支える注釈が、実は最も脆弱な部分でもあります。

3. 注釈精度を高めるための5つのポイント

- ガイドライン策定:ラベル定義を明確にし、曖昧さを排除します。

- 相互レビュープロセス:複数の注釈者が相互チェックし合い、異議は議論で解消。

- サンプル検証:ランダム抽出で数%の注釈を詳細チェック。

- 品質指標の導入:IoU(Intersection over Union)などの数値でチェック。

- 生成AIによる補助注釈:ChatGPTなどで候補を生成し、人間が精査する手法。

4. 業界事例:製造・医療・自動運転への応用

製造現場では、「傷あり/なし」のバイナリ分類で欠損検出を効率化。曖昧なら「要再確認」というタグを追加し、精度を維持。医療では、放射線医が病変領域を正確にアノテートしないと誤診のリスクが高まります。自動運転では、「歩行者」や「信号機」のラベルが曖昧だと事故原因に直結します。

5. Python実践:注釈データ処理サンプル

COCOデータセットは世界標準の画像認識アノテーション形式ですが、膨大なデータ量と巨大なJSONファイルが特徴です。フルセットで扱うのは大変なので、まずは部分データやチェックサンプルを作って、効率的なAI開発・検証を進めることが重要です。

ここでは、COCO形式アノテーションの品質チェックを自動化するPythonサンプルを紹介します。 このサンプルは、バウンディングボックス(bbox)の異常や、ラベルIDのミスを素早く検出でき、データの「バカな部分」を事前に発見できます。

import json

import os

def load_annotations(path='annotations.json'):

if not os.path.exists(path):

raise FileNotFoundError(f"ファイルがありません: {path}")

with open(path, 'r', encoding='utf-8') as f:

return json.load(f)

def check_annotations(ann):

issues = []

# COCOではcategory_idはint型、categoriesはid:int, name:strなどで構成

cat_ids = set(c['id'] for c in ann.get('categories', []))

for a in ann.get('annotations', []):

bbox = a.get('bbox', [])

if len(bbox) != 4:

issues.append((a.get('id'), 'bbox length error', bbox))

continue

x, y, w, h = bbox

if w < 1 or h < 1:

issues.append((a.get('id'), 'bbox too small', bbox))

if a.get('category_id') not in cat_ids:

issues.append((a.get('id'), 'invalid category', a.get('category_id')))

return issues

if __name__ == "__main__":

try:

ann = load_annotations()

issues = check_annotations(ann)

if issues:

print("注釈データの問題点一覧:")

for i in issues:

print(i)

else:

print("異常なし!")

except Exception as e:

print("エラー発生:", e)

【サンプルのポイント解説】

- データロード時の安全性 ファイル存在チェックと例外処理で「ファイルが無い」「JSON壊れてる」場合にも即座にエラーを通知します。

-

アノテーション検証

- bboxの4要素(x, y, w, h)が揃っているか確認

- 幅や高さ(w, h)が1未満の場合は異常扱い(極小・誤記など)

- category_idがcategories定義に存在しなければ異常

-

大規模COCOデータにも対応

- 膨大なCOCOファイルから一部サンプル抽出したJSONでもこのロジックは流用できます

- category_idセットを1回だけ作って高速化

-

現場活用Tips

- 異常検出リストをCSVで出力する、画像ファイル名を付与して「目で見て再確認」できる仕組みに拡張可能

- 自分のデータ規模に合わせて、サブセット抽出も併用すると良い

【COCOデータが大きすぎると感じたら?】

COCOフルセットは数十GB・数十万件にもなります。

まずは一部サンプル抽出して「小さく、速く」品質確認を進めましょう。

# サブセット例

import random

with open('instances_train2017.json') as f:

coco = json.load(f)

subset_ids = set(random.sample([img['id'] for img in coco['images']], 1000))

images = [img for img in coco['images'] if img['id'] in subset_ids]

annotations = [ann for ann in coco['annotations'] if ann['image_id'] in subset_ids]

new_coco = {'images': images, 'annotations': annotations, 'categories': coco['categories']}

with open('subset.json', 'w') as f:

json.dump(new_coco, f)

こうした下準備+品質チェックを組み合わせれば、 「バカなデータ」を効率よく抹殺し、AIの誤認識を根本から防ぐことができます。

6. まとめ:注釈主導のAI開発で信頼性を確保

注釈品質の重要性を見過ごすと、高性能なAIモデルでも現場での信頼性が失われます。「バカなデータは抹殺」し、誤認識を根絶するために、注釈主導の開発パイプラインはもはや“贅沢品”ではなく必須です。これにより、AIは本来の目的を果たし、安全性・公平性の高い社会実装が可能になります。