AIの未来を左右するのは「データの質」──Human in the Loopの本質的役割

Garbage in, garbage out. ── この言葉は、AIの本質を端的に表しています。どれほど精巧なアルゴリズムであっても、入力される学習データが不正確であれば、出力される結果もまた誤ったものとなります。

2025年5月、GlobeNewswireは、AIトレーニングデータセット市場が2034年までに184億ドル規模に成長すると予測するレポートを発表しました。背景には、Eコマースの拡大と大規模言語モデル(LLM)の急速な採用があります。

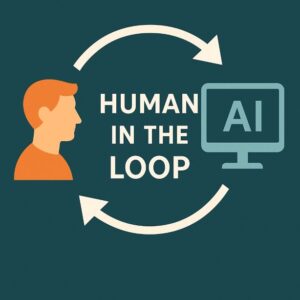

Human in the Loop(HITL)の重要性

Human in the Loop(HITL)とは、AIの学習や運用に人間が介在し、フィードバック、修正、アノテーションなどを行うプロセスを指します。これは単なる補助作業ではなく、「人間の知見」をAIに注入する極めて重要な役割です。

たとえば、医療画像診断ではAIが腫瘍の可能性を提示し、医師がその正否を判断することで学習精度が向上します。また、建設現場の損傷検知では、見た目が異常でも問題のない部材を人間が正しくラベル付けすることで、誤検出を防ぐことができます。

画一化のリスクと過去の失敗例

データが画一的であることのリスクは深刻です。たとえば、過去には以下のような例があります。

- 自動運転車がアメリカの道路標識を学習し、日本国内で誤認識を起こす

- 自然言語処理AIが「やばい」の多義性を理解できず誤った応答を返す

特筆すべきは、AmazonのAI採用システムの失敗です。同社は2018年に履歴書を自動選考するAIを導入しましたが、過去の男性中心の採用履歴を学習した結果、女性候補者を一律に過小評価するバイアスを持ってしまいました。このシステムは最終的に廃止されました(Reuters, 2018)。

学術的知見とHITLの再定義

近年の研究では、HITLは単なる「補助者」ではなく、AIの価値観や判断基準を設計する存在として再評価されています。たとえば、ACM Transactions on Interactive Intelligent Systemsの2024年の論文では、

HITLが介入する頻度とAIモデルの精度は、トレードオフではなく相補関係にある。

と述べられています。また、Stanford HAIでは、ChatGPTの進化において人間からのフィードバックを取り入れる「RLHF(Reinforcement Learning with Human Feedback)」が重要な役割を果たしたことが報告されています。

結論:人の知見とデータがAIを成長させる

AIの開発は技術的な問題だけでなく、「誰がどのようにデータを整備したか」に大きく左右されます。HITLによって「現場の経験」や「文脈理解」をAIに教えることこそが、社会に役立つAIを育てる鍵なのです。

「AIに仕事を奪われる」時代ではなく、「人とAIが一緒に学ぶ」時代にシフトするために、HITLは必須のフレームワークであり続けるでしょう。

この記事は以下の情報から引用してます